企业面临着数据量激增、数据源异构化、分析时效性要求提升等多重挑战。传统数据库系统虽然在结构化数据存储和查询上表现出色,但面对跨平台数据整合、实时处理需求时,往往受制于本地硬件资源和静态处理逻辑,导致数据管道效率低下、运维成本高的问题。

现在的企业需要一个更为强大的新一代数据集成工具来处理、整合并转化多种数据源。 ETLCloud作为新一代的ETL工具,能够有效帮助企业完成复杂环境下的数据集成。

下面我们将从数据源、离线数据集成和实时数据集成的角度讨论ETL与数据库的结合。

一、数据源

ETLCloud 是企业数据生态系统的“万能适配器”和“连接中枢”,能够消除数据源之间的隔阂,实现数据的自由流动,具备极其强大和灵活的数据源连接能力。支持各种多源异构数据对接,包括主流的关系型数据库、API、大数据、NOSQL数据库、文件等。这使得不同存储形式和数据库的数据能够有效集成和流通。

同时ETLCloud数据集成平台可以将所有数据清洗、转换、补全等处理工作在一个任务中完成,减少了繁琐的数据连接、数据输出和错误重试等数据开发时间。通过统一的数据源对接、数据转换清洗、数据输出和定时任务调度配置,可以提高至少80%的数据开发效率,让开发人员更专注于数据本身的价值。

内置的数据源模板只需几步简单配置就能帮助用户快速创建数据源。

二、离线数据集成

在企业的数据集成场景中,离线数据集成(Batch Data Integration) 是最常见、最基础的需求之一,主要用于处理非实时性的大规模数据同步、清洗和加载。ETLCloud采用全程可视化、拖拉拽的操作界面,用户只需单击几下即可快速创建数据管道,提供了高效、稳定、易用的数据清洗和转换能力。

同时拥有上百种组件功能,能够满足复杂的数据处理需求。

ETLCloud遵循BPMN2.0规范来设计流程,BPMN2.0规范支持设计任务复杂的数据处理流程,串行、并行、子流程、循环、异步执行等等均不在话下。

在百万级至千万级别对比下从平均值来看,ETLCloud平均比kettle快24.16%,比DataX快27.8%。

三、实时数据集成

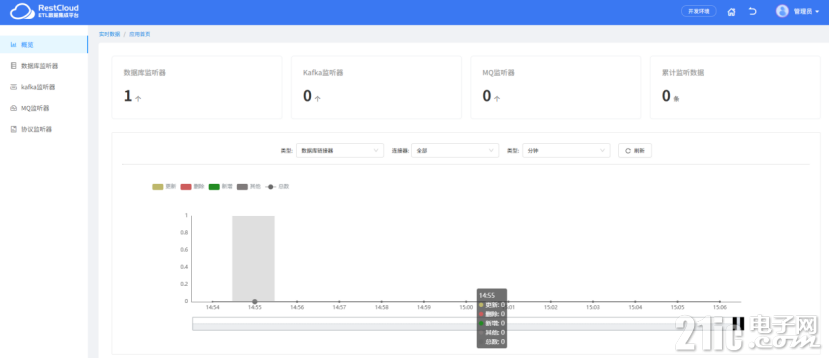

实时数据传输指的是将数据从源系统(如数据库、应用程序、传感器等等)实时地传输到目标系统的过程。在此过程中,数据可以在产生时立即进行传输,以及实时的业务决策和操作。相比于批量处理方式,实时数据传输可以在最短时间内得到可用数据,并且可以更快地响应客户需求,从而提高业务效率和生产力。而ETLCloud支持CDC实时数据同步能力,通过开启数据库的日志,实现实时数据的监听传输,整个步骤只需要通过简单的配置即可快速完成。另外还支持kafka、各种MQ消息的监听以及推送。

同时,ETLCloud在实时数据传输过程中支持数据质量检查。它可以实时识别并分发脏数据到指定表中,并发送告警通知,确保数据的准确性和可靠性。

四、总结

ETLcloud 与传统数据库的结合,绝非简单的工具叠加,而是一次数据处理范式的升级。

它打破了企业间的数据孤岛,释放了数据库潜能,将复杂、低效、高成本的数据处理过程,转变为可视化、自动化、高性能、高质量的现代化数据流水线。

无论是追求实时洞察、构建统一数据视图,还是强化数据治理、提升分析效率,ETLcloud 都是企业解锁数据价值、驱动智能化决策的极佳选择。