|

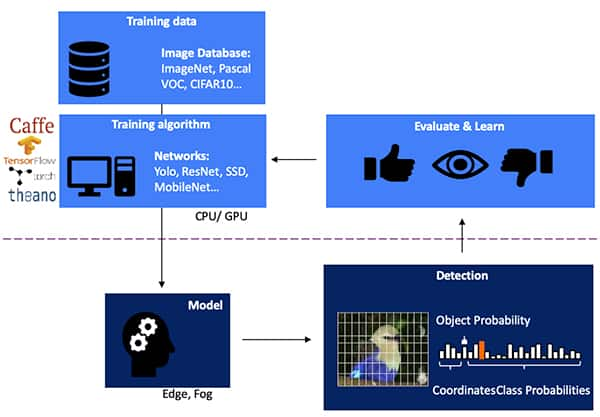

利用 FPGA 快速路径构建高性能、高能效边缘 AI 应用 [color=var(--slate-grey)]作者:Stephen Evanczuk [color=var(--slate-grey)]投稿人:Digi-Key 北美编辑 2021-01-12 [color=var(--slate-grey)]对于希望在边缘的推理处理器上实施人工智能 (AI) 算法的设计人员来说,他们正不断面临着降低功耗并缩短开发时间的压力,即使在处理需求不断增加的情况下也是如此。现场可编程门阵列 (FPGA) 为实施边缘 AI 所需的神经网络 (NN) 推理引擎提供了特别有效的速度和效率效率组合。然而,对于不熟悉 FPGA 的开发人员来说,传统 FPGA 的开发方法可能相当复杂,往往导致他们去选择不太理想的解决方案。 [color=var(--slate-grey)]本文将介绍来自 Microchip Technology 的一种比较简单的方法。通过这种方法,开发人员可以使用 FPGA 和软件开发套件 (SDK) 构建经过训练的 NN,或者使用基于 FPGA 的视频套件立即启动智能嵌入式视觉应用开发,从而避开传统的 FPGA 开发。 为什么要在边缘使用 AI?[color=var(--slate-grey)]边缘计算为物联网 (IoT) 应用带来了诸多好处,涵盖了包括工业自动化、安全系统、智能家居等在内的多个领域。在以工厂车间为目标的工业物联网 (IIoT) 应用中,边缘计算通过避免到云端应用的往返延迟,可以显著缩短过程控制环路的响应时间。同样,基于边缘的安全系统或智能家居门锁即使由于意外或人为原因与云端的连接断开时,也能继续正常工作。在很多情况下,在任何此类应用中使用边缘计算时,都可以通过减少产品对云资源的依赖来帮助降低整体运营成本。随着产品要求的提高,开发者可以依靠产品中内置的本地处理功能去帮助维持更稳定的运营开支,而不会面临增加昂贵的云资源的意外需求。 [color=var(--slate-grey)]对机器学习 (ML) 推理模型的快速接受和需求的增加,极大地提高了边缘计算的重要性。对于开发人员来说,推理模型的本地处理能力有助于降低云端推理所需的响应延迟和云资源成本。对于用户来说,使用本地推理模型会让他们更加相信,其产品在偶尔与互联网断开或基于云的供应商产品发生变化时仍能正常运行。此外,在安全和隐私方面的担忧会进一步推动对本地处理和推理的需求,以限制通过公共互联网传输到云端的敏感信息数量。 [color=var(--slate-grey)]为基于视觉的对象检测开发 NN 推理模型是一个多步骤过程。首先进行模型训练,这一步通常在 TensorFlow 等 ML 框架上使用公开的标记图像或自定义的标记图像进行训练。由于处理需求,模型训练通常使用云端或其他高性能计算平台的图形处理单元 (GPU) 进行。训练完成后,模型被转换为能够在边缘或雾计算资源上运行的推理模型,并将推理结果以一组对象类概率的形式交付(图 1)。 [color=var(--slate-grey)]  图 1:在多步骤过程的末端实现边缘人工智能的推理模型,需要使用现有或定制型训练数据在框架上训练和优化 NN。(图片来源:Microchip Technology) 图 1:在多步骤过程的末端实现边缘人工智能的推理模型,需要使用现有或定制型训练数据在框架上训练和优化 NN。(图片来源:Microchip Technology)

|